Apple se brání kritice ze šmírování uživatelů. Odmítneme identifikovat cokoliv kromě zneužití dětí, říká

Apple se pokusil udělat dobrou věc, když před několika dny představil systém na vymycování sexuálních záznamů dětí (CSAM). Mnozí odborníci na digitální bezpečnost nebo organizace pro ochranu soukromí ale jeho záměr začali okamžitě ostře kritizovat. Skenování fotek uživatelů, jakkoliv anonymizované, podle nich může vést ke katastrofickým scénářům. Apple si ale zatím stojí za svým a v novém dokumentu ujišťuje, že zneužití systému nikdy nedopustí.

Na část svého webu, která se zabývá novými technologiemi pro ochranu dětí, teď firma doplnila sekci Často kladených otázek (FAQ), ve které se snaží na pravou míru uvést některá nedorozumění. Vedle toho jsou pak prohlášení, kterým nejspíš i nadále zůstane aura kontroverze. Nestojí totiž na technologickém řešení, ale hlavně slibech a ujištěních. U nejproblematičtějších aspektů systému pro identifikaci CSAM jim ani nic jiného nezbývá.

Nový systém Applu pro ochranu dětí zahrnuje tři hlavní části, které jsme blíže popsali v předchozím článku. Jedna z nich se zaměřuje na výsledky hledání a Siri, zobrazující upozornění v případě hledání potenciálně závadného sexuálního obsahu. Druhá je spojená s aplikací Zprávy – po aktivaci funkce dostanou děti mladší 13 let a jejich rodiče upozornění při přijetí nebo odesílání explicitních obrázků či videí. Ani v jednom ze dvou případů se nenaruší šifrování a Apple se o ničem nedozví.

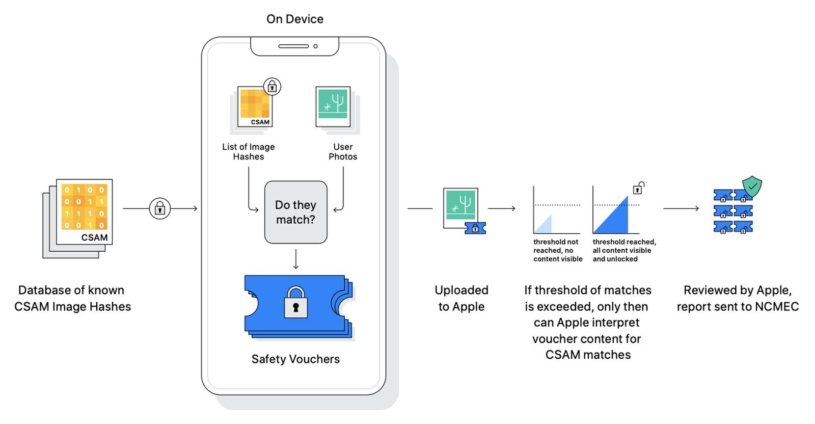

Případné informování Applu a následně bezpečnostních složek je naopak zásadní při třetí představené funkci, která se týká lidí používajících iCloud pro zálohu galerie. Pro každou fotku a video se před nahráním do cloudu přímo v zařízení vytvoří unikátní identifikační kód, z něhož nelze zpětně získat původní soubor. Tento kód, tzv. hash, se pak porovná s hashi vytvořenými z databáze známých CSAM materiálů od centra National Center for Missing and Exploited Children (NCMEC).

Pokud nastane shoda, daný obrázek dostane speciální značku a spolu s ní se nahraje na iCloud. Apple je o všem informován až v případě, že se takových shod u jednoho uživatele identifikuje větší množství – dříve to technologicky není možné. Záležitost pak dostane na starost zaměstnanec firmy, který manuálně vyhodnotí, zda se opravdu jedná o závadný obsah a ne jen náhodnou shodu. Taková se má objevovat pouze jednou v bilionu případů ročně.

Jako největší problém funkce pro odhalování CSAM materiálů kritici vidí obsah databáze, se kterou se fotografie uživatelů porovnávají. Ačkoliv nikdo bez přístupových údajů k danému účtu nemůže získat přístup k jiným souborům než těm se stejným hashem jako obsah databáze, tím může být teoreticky cokoliv.

Například organizace EFF upozornila na jednu konkrétní databázi, která původně také sloužila k identifikaci CSAM materiálů. Postupně se ale do ní zcela netransparentně začaly přidávat i další, jež byly spojené s terorismem nebo jinými záznamy „nevyhovujícího“ chování. Pokud by tedy například Čína donutila Apple svůj systém napojit na podobnou, státem kontrolovanou databázi, mohla by iPhony využívat jako „práskače“ třeba pro protestující v Hongkongu.

Odmítneme identifikovat cokoliv kromě zneužití dětí

Firma tak podle některých chystá do svých operačních systémů nainstalovat zadní vrátka, která by působila tak, že zachovávají soukromí, ve skutečnosti by ale byla snadno zneužitelná. Právě tento moment společnost Tima Cooka v novém dokumentu vehementně odmítá. „Náš systém je navržený tak, aby pracoval výhradně s hashi CSAM obrázků poskytnutými NCMEC a dalšími organizacemi pro ochranu dětí,“ stojí v něm.

Nastartujte svou kariéru

Více na CzechCrunch JobsKromě toho nemá nikdy dojít k automatickému informování bezpečnostních složek a případné shody vždy nejdříve vyhodnotí pracovníci Applu. Novinář John Gruber k tomu na svém blogu dodává, že podle technických specifikací to neznamená, že by kdokoliv mimo uživatele dostal přístup přímo k obsahu jeho zařízení či cloudu. Při vytváření hashů totiž vznikne také kopie fotografie v nízké kvalitě.

Pokud tedy bude pracovník Applu provádět vizuální kontrolu nalezených shod, vždy bude mít k dispozici jen nekvalitní kopie původních fotografií. Ty i nadále zůstanou zcela zašifrované a přístupné pouze těm, kteří znají přístupové údaje k danému účtu (+ další vrstva ochrany u dvoufaktorového ověřování).

Databáze jako NCMEC, jejichž hashe CSAM materiálů Apple při identifikaci používá, prý nikdy nebude obsahovat jiné než pornografické záznamy nezletilých. Na otázku, zda může být přinucena k identifikování jiného typu obsahu, firma jednoznačně odpovídá slovy: „Apple jakékoliv podobné požadavky odmítne.“

V minulosti se skutečně objevily příklady přesně takového jednání ze strany společnosti. Různé bezpečnostní složky na ni dlouhodobě tlačí ve snaze oslabit šifrování jejích systémů, ale bez úspěchu. Nejznámějším příkladem je situace z roku 2016, kdy Apple odmítl pomoci FBI odemknout iPhone zadržených teroristů a byl ochoten jít až k soudu. Žádná jiná vláda prý firmu o něco podobného nežádala.

Na druhou stranu stále platí, že se pravidelně píše o ústupcích Applu vládám některých zemí, hlavně Číny. Vyhovuje jí například v požadavcích mazání tisíců aplikací z App Storu nebo ukládá (byť šifrovaná) data na lokálních serverech, které má pod kontrolou stát. V těchto případech se sice jedná o vyhovění místním zákonům, teoreticky ale nic nebrání ve vzniku zákona vyžadujícího identifikaci jiných než CSAM materiálů.

Apple ve svém dokumentu zdůrazňuje, že americká vláda od provozovatelů cloudových služeb už déle vyžaduje kontrolu obsahu pro CSAM. Ve většině případů to prý skutečně znamená ohrožení soukromí všech, co cloud používají. Nový systém výrobce iPhonů ale má být schopný požadavek vlády splnit, aniž by jakkoliv narušil soukromí uživatelů, kteří dětskou pornografii v iCloudu nemají.

Obecně nové FAQ vysvětluje některá neporozumění šířená i seriózními médii. Například zdůrazňuje, že systémy pro kontrolu zpráv a iCloudu jsou zcela separátní a služba iMessage tak zůstává plně šifrovaná – nikdo nezjistí, i kdyby ji dospělý používal ke sdílení CSAM. Opakuje také, že nový systém pro identifikaci dětské pornografie se nijak netýká uživatelů, kteří nepoužívají iCloud k záloze fotek.

Některé jeho aspekty nicméně stále zůstávají jen na úrovni „Apple to nedopustí a nepodvolí se požadavkům zemí“ a jako takové budou i nadále kontroverzní. Nové funkce pro ochranu dětí mají přijít na podzim s vydáním iOS 15, iPadOS 15, watchOS 8 a macOS Monterey, přičemž se zpočátku mají týkat výhradně amerických uživatelů. Dále se mají rozšiřovat po jednotlivých zemích podle toho, jak firma domluví spolupráci s místními organizacemi.