Apple staví na ochraně soukromí, nově chce chránit děti skenováním fotografií uživatelů. Kritici se bojí zneužití

Moderní diskuze o soukromí se vždy dříve nebo později dostane k otázce bezpečí – jsme ochotní se vzdát části jednoho, abychom zvýšili druhé? Budeme tolerovat ulice poseté kamerami, když to usnadní pronásledování kriminálníků? Apple se v tomto směru většinou staví na stranu zachování soukromí, za což dostává nemálo chvály. Teď se ale středem pozornosti stala nová funkce iOS, která má pro eliminaci záznamů zneužívání dětí skenovat fotografie uživatelů.

Problém samozřejmě neleží tam, kde by se to na první pohled mohlo zdát. Apple ani nikdo jiný uživatele nebude špehovat, neuvidí, co je na fotografiích, a pokud nenarazí na předem definované problematické záznamy, nedokáže je propojit s konkrétním člověkem. Kalifornská firma právě kvůli tomu vyvinula vlastní systém s komplexní ochranou proti většímu zásahu do soukromí, než je nutné pro identifikaci závadných fotografií či videí.

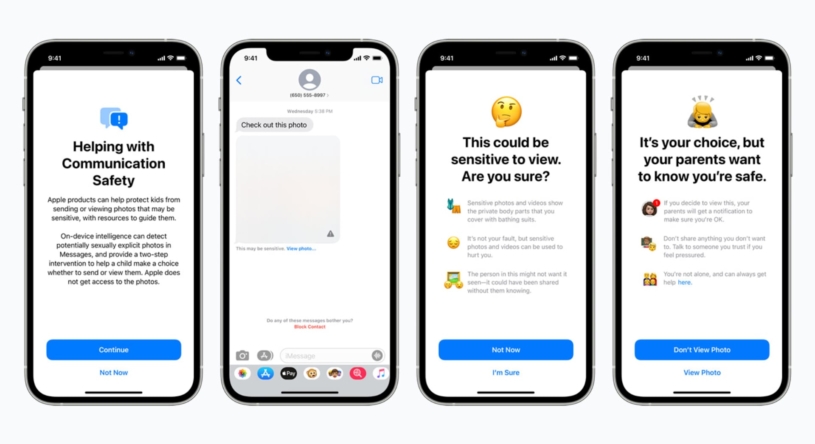

Aktualizace chystané pro podzimní iOS 15, iPadOS 15, watchOS 8 a macOS Monterey zahrnují trojici novinek. Zaprvé jde o funkci identifikující sexuálně explicitní materiály ve zprávách iMessage. Pokud rodič funkci aktivuje a dítě se explicitní obrázek pokusí odeslat, zařízení zobrazí upozornění, které je nutné potvrdit. V případě potvrzení a odeslání může být u dětí mladších třinácti let informován také rodič.

Totéž se děje v případě, že dítěti ve zprávě dorazí potenciálně závadný obsah. Nejdříve mu dorazí rozmazaný obrázek s upozorněním, a pokud ho odsouhlasí, dozví se o tom rodič. V obou případech probíhá analýza zpráv přímo v zařízení, takže k nim nemá přístup nikdo kromě odesílatele a adresáta. iMessage i nadále zůstávají plně end-to-end šifrované.

Druhá novinka se týká Siri a vyhledávání na webu. Pokud se kdokoliv pokusí vyhledat obsah spojený se sexuálním zneužíváním dětí, zařízení mu zobrazí odrazující upozornění a odkazy na případnou pomoc. Tu půjde vyžádat také přímo, přičemž ani v jednom případě nemá probíhat jakékoliv nahlašování Applu nebo třetí straně.

Skenování fotografií a videa bez narušení soukromí

Hlavní, a také nejvíce kontroverzní aktualizace se týká přímo skenování fotografií a videí uživatelů pro identifikaci závadného obsahu s dětmi. Vlastní systém Applu, který má pomoci závadný obsah rozpoznávat, prý totiž v zájmu ochrany dětí potenciálně otevírá jakási zadní vrátka ke zneužití ze strany nejen autoritářských režimů. Nejdříve si ale přibližme, jak skenovací funkce funguje.

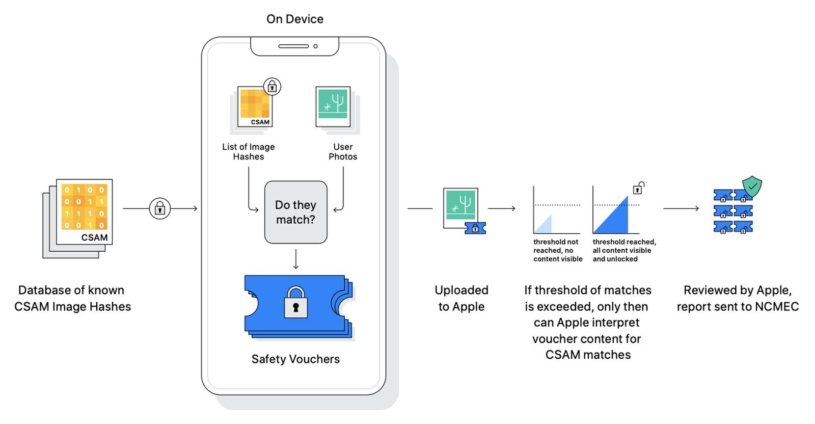

V základu je to poměrně jednoduché. Než se vizuální záznam odešle do iCloudu, přímo v zařízení proběhne jeho porovnání s existující databází CSAM (Child Sexual Abuse Material), neboli sexuálně explicitního obsahu s dětmi. To probíhá v zašifrované formě, aby nikdo kromě uživatele nemohl dané soubory skutečně zobrazit. Až v případě opakovaných shod probíhá jejich nahlášení bezpečnostním složkám. Pokud tedy člověk v galerii nemá závadný obsah, žádná třetí strana ho nikdy neuvidí.

Nastartujte svou kariéru

Více na CzechCrunch JobsApple proces do detailu popisuje na vlastním webu, kde můžeme nalézt detaily o eliminaci falešných shod a zajišťování soukromí. Například se neporovnávají obrázky, ale tzv. hashe, tedy řetězce čísel a písmen, které speciální algoritmus vytváří přímo v zařízení zvlášť pro každou fotografii či video. Stejný hash přitom dostanou i fotografie vyobrazující totéž, ale jsou ořezané, otočené nebo převedené na černobílé. Apple algoritmu říká NeuralHash.

Jím vytvořený řetězec není možné převést zpátky na obrázek, takže umožňuje identifikovat stejné soubory bez znalosti jejich obsahu. Hashe obrázků a videí uživatelů se pak – opět přímo v zařízení před nahráním na iCloud – porovnávají se CSAM hashi bezpečně uloženými v paměti telefonu, tabletu, počítače či hodinek. Hashe se sexuálně explicitním obsahem s dětmi Apple získá od americké organizace National Center for Missing and Exploited Children (NCMEC), která spolupracuje s bezpečnostními složkami.

To znamená, že Apple může identifikovat shody pouze s již známými CSAM materiály, které jsou v oběhu déle. Díky tomu se takřka eliminuje možnost nahlašování například fotografií koupajících se dětí, které bez špatného úmyslu pořizují rodiče. Zároveň detekci unikne nově vytvořený závadný obsah, stejně jako uživatelé, jež pro zálohování obrázků a videí nepoužívají iCloud.

Pokud se v zařízení identifikuje jedna shoda, prostřednictvím protokolu private set intersection (PSI) je vytvořen tzv. kryptografický bezpečnostní voucher, tedy jakési označení závadnosti fotografie, které se spolu s ní nahraje na iCloud. O jednotlivých voucherech není informován ani uživatel, ani Apple, který je samostatně nedokáže přečíst a spojit s konkrétními soubory. Tato možnost se odemkne až při překročení určitého (nespecifikovaného) počtu shod, přičemž pravděpodobnost chyby je prý jedna ku bilionu ročně.

Až v momentě, když systém pomocí porovnávání hashů s databází identifikuje větší počet shod, se o všem dozví Apple a dostane přístup k označeným fotografiím uživatele. Správnost identifikace pro téměř naprosté vyloučení falešné shody zkontroluje lidský pracovník a případně informuje organizaci NCMEC. Účet Apple ID daného uživatele je zablokován, ten se vůči rozhodnutí ale může stále odvolat.

Tento systém, detailně popsaný na webu Applu, v určitém směru vylepšuje už déle prováděné skenování potenciálních materiálů se sexuálně explicitním obsahem s dětmi přímo na iCloudu, které se děje na většině (ne-li všech) cloudových službách. Novinka má od podzimu fungovat pouze ve Spojených státech ve spolupráci se zmíněnou organizací NCMEC. Po prvotním ohlášení pak Apple potvrdil, že rozšíření do dalších zemí má probíhat jednotlivě, podle místních organizací a zákonů.

Podle kritiků může být systém Applu zneužit

Právě tohoto vývoje se obávají kritici představeného systému. Pro autoritářské, ale také demokratické, režimy nemusí být těžké do kontrolní databáze kromě CSAM zahrnout také jiné typy obsahu, jako například potenciální kriminální aktivitu, záznamy politického disentu či jakékoliv jiné materiály. Apple se prý může ohánět technologiemi zajišťujícími perfektní soukromí, ty samé technologie ale mohou být zneužity i pro přesný opak.

Například kryptograf Matthew Green z americké Univerzity Johnse Hopkinse na Twitteru uvedl: „Ten, kdo tento seznam ovládá, může ve vašem telefonu vyhledávat libovolný obsah a vy nemáte žádnou možnost zjistit, co na seznamu je, protože je pro vás neviditelný (a je to jen hromada neprůhledných čísel, i když se do telefonu nabouráte, abyste seznam získali).“

Edward Snowden, který před lety odhalil rozsáhlé sledovací systémy FBI, na Twitteru sdílel ještě radikálnější komentář Sarah Jamie Lewisové, šéfky organizace Open Privacy zaměřené na digitální soukromí: „Když to shrneme, Apple navrhl, aby se váš telefon stal černou skříňkou, která o vás může příležitostně podávat zprávy, jež se mohou shromáždit a informovat příslušné orgány.“

Mezinárodní nezisková organizace zaměřená na osobní svobodu v digitální éře Electronic Frontier Foundation upozornila, že varovné hlasy přitom mají oporu v již existujících systémech. Jeden takový, podobný novince Applu, využívá databázi Global Internet Forum to Counter Terrorism obsahující údajné záznamy činů spojených s terorismem. Přesný obsah databáze je prý velice netransparentní a postrádá relevantní dohled, který by předešel zneužívání pro utlačování lidí.

Přinejmenším teoreticky například neexistuje důvod, proč by se v ní nebo jí podobné nemohly objevit záznamy protestujících v Hongkongu. Jelikož čínská vláda její kritiku staví na roveň s terorismem, identifikovaní uživatelé by mohli strávit zbytek života ve vězení. Nový systém Applu podle některých představuje bezprecedentní rozšíření potenciálu takových výsledků.

Nezanedbatelná část výtek se obrátila také na aktualizaci pro iMessage, která naivně předpokládá, že rodič je vždy ta správná osoba, s níž informaci o zasílání potenciálně sexuálních záznamů sdílet. Například homosexuální nebo transgender děti kvůli tomu mohou čelit větší, ne menší míře psychického či fyzického teroru.

Jak uvedl magazín 9to5Mac, společnost Apple v reakci na kritiky rozeslala interní dopis, kde její viceprezident vývoje softwaru Sebastien Marineau-Mes ujišťuje, že vychází z neporozumění. „Budeme pokračovat ve vysvětlování a podrobném popisu funkcí, aby lidé pochopili, co jsme vytvořili,“ napsal Marineau-Mes. Znovu přitom zdůraznil, jak důležitý je záměr chránit děti.

Soukromí a bezpečnost dat uživatelů je pro Apple jedním ze stěžejních témat už mnoho let, výkonný ředitel Tim Cook ho dokonce pro lidstvo označil za stejně zásadní jako klimatické změny. Před několika lety ostatně jeho firma důsledně odmítla spolupracovat s FBI na odemčení iPhonů teroristů, což podpořili i ostatní technologičtí giganti. Sám Apple argumentoval, že pokud by umožnil nahlédnout do obsahu jednoho zařízení (k čemuž nemá potřebnou technologii), šlo by prolomit bezpečnost také u všech ostatních.

V případě plánovaného systému na skenování fotografií za účelem nalezení potenciálně závadného obsahu jsou důležitou součástí jednak domluva s konkrétními zeměmi a databázemi, jednak jeho poslední krok, kdy mají idenfitikované shody kontrolovat zaměstnanci firmy. Samozřejmě se ovšem objevily názory, podle nichž například Čína může po výrobci iPhonů požadovat spolupráci. Nebylo by to poprvé, jak naposledy ukázala omezená dostupnost ochrany soukromí při používání prohlížeče Safari právě v Číně.

Naopak je zase otázkou, zda systém pro ochranu dětí, který teď Apple zveřejnil a poměrně do detailu popsal, vůbec může fungovat. Lidem s úmyslem uchovávat nebo sdílet materiály se sexuálně explicitním obsahem s dětmi stačí vědět, že pokud nebudou používat iCloud a iMessage, detekci se vyhnou. Firma tak dle některých odborníků možná riskuje bezpečí a soukromí mnoha ve jménu zcela neefektivní ochrany, jelikož pro dosažení svých záměrů zvolila špatnou cestu.