Apple odkládá funkce pro ochranu dětí před sexuálním obsahem. Chce co nejlépe reagovat na ostrou kritiku ze šmírování

Apple před několika týdny představil nejkontroverznější funkci iOS za velmi dlouhou dobu – ochranu proti šíření sexuálně explicitního obsahu s dětmi (CSAM). Jelikož funkce má porovnávat digitální otisky fotografií v iCloudu uživatelů s databází známých CSAM, okamžitě se objevily obavy ze zneužití a osočení, že výrobce vytvořil zadní vrátka do svých operačních systémů. Firma se proto teď rozhodla spuštění nových funkcí odložit.

Podle oficiálního vyjádření to prozatím neznamená, že Apple nakonec nový systém pro identifikaci CSAM nenasadí. Má ho pouze upravit. „Na základě zpětné vazby od zákazníků, ochránců práv, expertů a dalších jsme se rozhodli, že v následujících měsících strávíme více času shromážděním podnětů a vylepšováním těchto prvků kritiky důležitých pro bezpečnost dětí předtím, než je vydáme,“ stojí v oficiálním vyjádření.

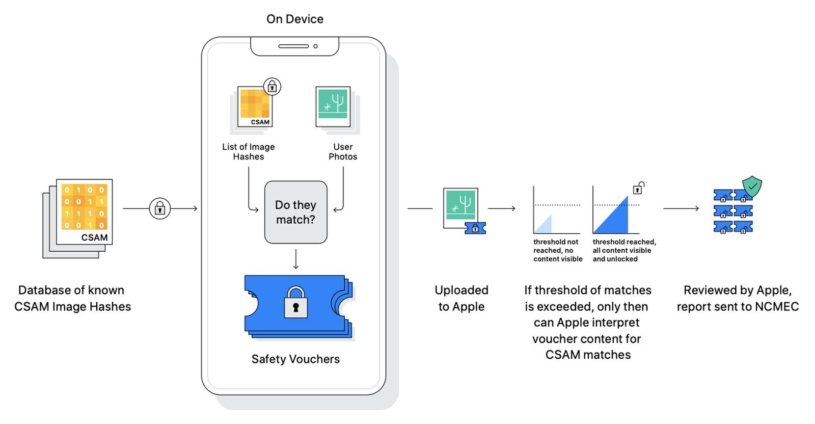

Apple na počátku srpna představil trojici nových funkcí pro ochranu dětí před sexuálním zneužitím. Jedna měla uživatele upozornit, pokud by se přes Siri nebo Safari pokusil vyhledat CSAM obsah. Druhá přímo v zařízení identifikovala potenciálně sexuální obrázky a varovala děti, když se jim je pokusil někdo poslat, nebo je naopak chtěly sdílet. Třetí pak měla bezpečně skenovat fotky a videa nahrávané do iCloudu, vytvářet k nim identifikační kódy (hashe) a ty porovnávat s databází známých CSAM materiálů.

Spolu s ohlášením funkcí Cookova firma detailně popsala, jak fungují, jak chrání soukromí uživatelů a jak se vyhýbají zneužití. Jelikož měla třetí zmíněná funkce například dokázat idenfitikovat i pozměněné obrázky, vytvářené kódy nebyly zcela přesné a umožňovaly tak falešné shody. Aby se v takovém případě okamžitě nespustilo ohlášení Applu, systém měl vyžadovat určitý vyšší počet shod, bez jehož dosažení by nebylo možné určit, kdo potenciální CSAM v iCloudu má.

Databáze, se kterou se mělo hashe porovnávat, pak patří dobře známé a spolehlivé americké neziskové organizaci NCMEC. I kdyby do ní ovšem třeba FBI propašovalo jiný obsah než dětskou pornografii, systém Applu na konci vyžaduje manuální ověření pracovníkem firmy, který v případě falešné shody žádné informace dále nepředá.

Nastartujte svou kariéru

Více na CzechCrunch JobsNa internetu se přesto okamžitě rozpoutala bouře kritiky, částečně vycházející z neporozumění fungování nových funkcí, částečně z obav o jejich zneužití. Třeba Edward Snowden citoval tweet šéfky organizace na ochranu digitálního soukromí: „Apple navrhl, aby se váš telefon stal černou skříňkou, která o vás může příležitostně podávat zprávy, jež se mohou shromáždit a informovat příslušné orgány.“

Podobné komentáře, zaměřené hlavně na netransparentnost obsahu srovnávací databáze, se objevily z mnoha stran. Organizace Electronic Frontier Foundation upozornila na jinou databázi, jejíž cílem bylo zpočátku také identifikovat pouze CSAM obsah. Postupně se do ní ale začaly dostávat také jiné typy fotografií a videí a potenciálně může sloužit k rozeznávání čehokoliv.

Apple se na vlnu kritiky snažil reagovat vydáním dalších upřesňujících informací nebo také přímo rozhovorem, který šéf softwaru firmy Craig Federighi poskytl The Wall Street Journal. Zaznělo zde, že značná část kritiky vycházela z pomýlení vlastností dvou zcela samostatných funkcí pro ochranu dětí v iMessage a pro skenování iCloudu.

Kromě toho znovu vysvětlil, jak přesně má nový systém fungovat a ujistil, že Apple neuvidí žádný obsah zařízení ani iCloudu uživatelů mimo už známé CSAM materiály. V rozhovoru zazněla také reakce na možné zneužití ze strany vlád a vládních organizací. Federighi jednak poznamenal, že v Cupertinu by se podobnému tlaku nikdy nepodvolili. Navíc, i kdyby se tak prý stalo, několik bodů kontroly by umožnilo takové selhání snadno odhalit.

Argumenty varující před vlivem autoritářských vlád na konání Applu spoléhají na tzv. nakloněnou rovinu. Říkají, že když Apple dokáže identifikovat CSAM, proč by nemohl být donucen třeba k identifikaci protestujících v Hongkongu. To je na první pohled zcela legitimní otázka, stejně tak se ale můžeme ptát, proč Čína nedonutila Apple vytvořit zadní vrátka už dávno. Kdyby se tak ostatně stalo, firma by to jistě otevřeně nekomunikovala veřejnosti, jak to činí s ohlášeným systémem.

Proto také zůstává velkou otázkou, co může Apple změnit, aby se jeho systém zmíněné kritice vyhnul. Samozřejmě se objevily spekulace, že jeho odložení představuje hlavně snahu udobřit si veřejnost nedlouho před očekávaným ohlášením nových iPhonů. Alternativou je také faktické zrušení systému s tím, že navenek firma nechtěla přiznat porážku a ohlásila tak jen odklad. Každopádně dobré záměry Cookovy společnosti prozatím selhaly a bude zajímavé sledovat, jak se situace vyvine dále.